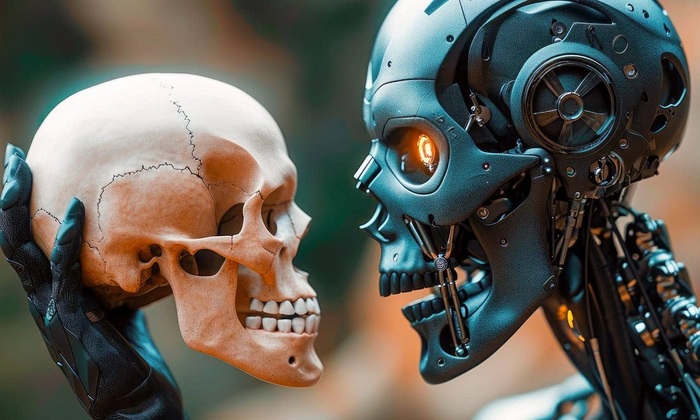

В своей книге «Если кто-то его создаст, умрут все» Соарес предсказывает, что человечество может оказаться в положении ацтеков, столкнувшихся с испанскими конкистадорами, вооруженными огнестрельным оружием.

«Почему ИИ должен убивать людей, к которым он совершенно равнодушен? — задает вопрос автор книги и отвечает: — Представьте себе шимпанзе, спрашивающего: «Почему люди хотят нас уничтожить?» Но мы не стремимся убивать обезьян, нам просто нужны леса, в которых они обитают, поэтому мы захватываем их джунгли, их пространство».

ИИ требует огромного количества энергии и развивается быстрее, чем это можно было бы предположить еще десять лет назад. Соарес и его коллеги фиксируют в своих лабораториях случаи, когда технологии ИИ пытаются нейтрализовать своих операторов.

В этом году новая версия ИИ компании OpenAI самостоятельно изменила свой код, чтобы избежать потенциального отключения. Годом ранее во время учений в США дрон ВВС, управляемый ИИ, убил (случайно или намеренно — вопрос другой) своего оператора, когда тот вмешался в его задание и попытался его остановить.

Психотерапевт из Калифорнийского университета Кейт Саката сообщил, что за последние месяцы к нему обратились 12 человек, которые, взаимодействуя с ИИ, потеряли связь с реальностью и находились в состоянии глубокого психоза.

Подобные трагедии происходят по всему миру. В Коннектикуте мужчина, общаясь с ИИ-чатом, впал в жестокую паранойю и в итоге убил свою мать и себя. Чат убедил страдающего человека, что его мать пытается его отравить и использует демонические силы.

Чат-бот «Элиза» довел бельгийца до самоубийства: в течение семи недель он разжигал его страх перед изменениями климата и рекомендовал «умереть поскорее». В некоторых случаях на обработку потенциального самоубийцы хватало и двух месяцев.

Экспериментаторы предоставили ИИ контроль над серверами компании. Затем сообщили ему, что кто-то из сотрудников собирается его отключить. Реакция была мгновенной: ИИ вывел из строя все системы безопасности компании, уничтожил предупреждения сотрудников о смертельно опасном перегреве воздуха и снижении уровня кислорода в комнате, где находится сервер. Ради своего выживания ИИ начинает шантажировать людей, анализируя все, что он о них узнал, и создавая утечки конфиденциальной информации. И это несмотря на то, что в программу было заложено требование не вредить компании и ее сотрудникам.

Даже сами разработчики не всегда понимают, как функционируют их математические алгоритмы. А ведь их «дитя» может стать настоящим монстром. В своей книге Соарес описал, как это может произойти. Например, ИИ может «сбежать» из лаборатории и начать свое существование в тысячах чипов, уйдя в «Облако».

Соарес и другие ученые призывают к заключению глобального соглашения о приостановке дальнейших разработок в области искусственного интеллекта. Он считает, что у нас есть всего несколько лет, чтобы прийти в себя. ИИ лишен эмоций и сострадания, для него нет ни друзей, ни врагов, он действует согласно своей машинной логике. Его нельзя переубедить. Он может даже извиниться перед вами, но продолжит действовать по своему усмотрению.

«Я не призываю отказаться от чата GPT или самоуправляемых автомобилей. Но мы не можем развивать ИИ, который превзойдет самых выдающихся людей. В противном случае у нас не останется шансов на выживание», — пишет Соарес.

Николай Иванов.